题目要求

建立房价预测模型:利用ex1data1.txt(单特征)和ex1data2.txt(多特征)中的数据,进行线性回归和预测。

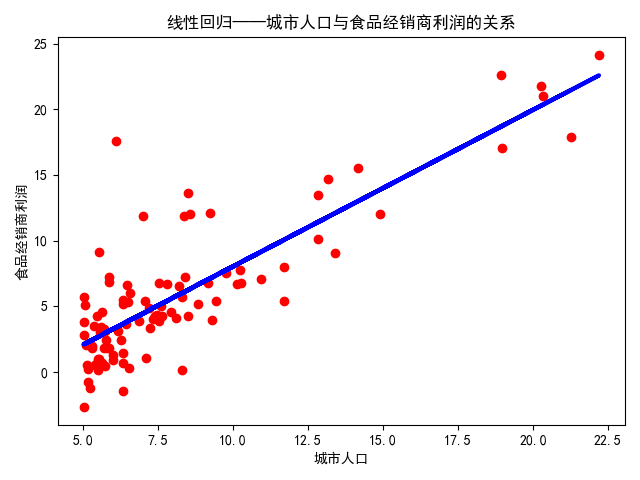

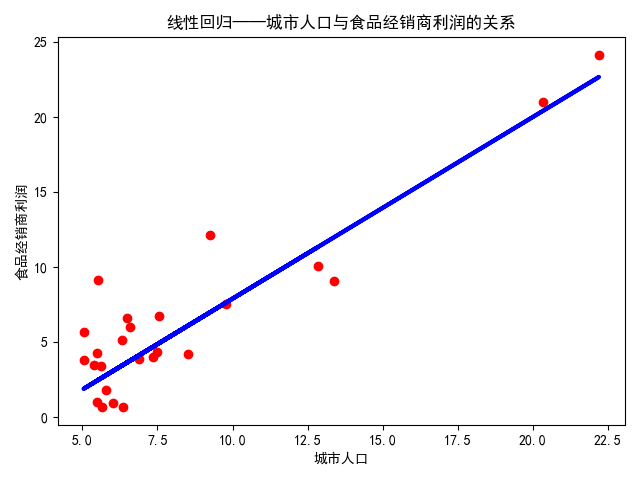

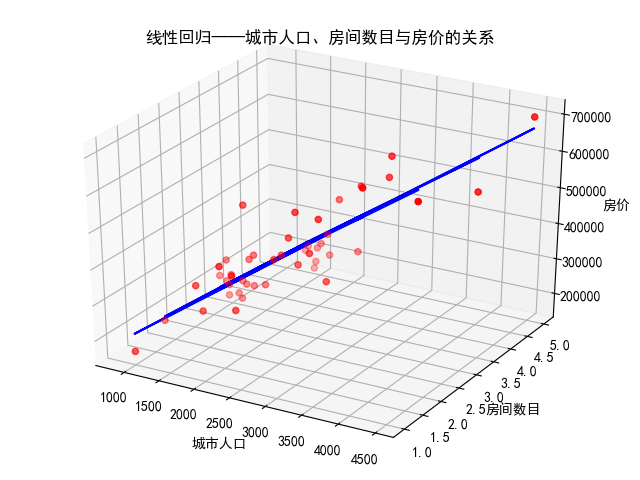

作散点图可知,数据大致符合线性关系,故暂不研究其他形式的回归。

两份数据放在最后。

单特征线性回归

ex1data1.txt中的数据是单特征,作一个简单的线性回归即可:$y=ax+b$。

根据是否分割数据,产生两种方案:方案一,所有样本都用来训练和预测;方案二,一部分样本用来训练,一部分用来检验模型。

方案一

对ex1data1.txt中的数据进行线性回归,所有样本都用来训练和预测。

代码实现如下:

1 | """ |

结果如下:

由下可知函数形式以及$R^2$为0.70

1 | [1.19303364] |

方案二

对ex1data1.txt中的数据进行线性回归,部分样本用来训练,部分样本用来预测。

实现如下:

1 | """ |

结果如下:

由下可知函数形式以及$R^2$为0.80

1 | [1.21063939] |

多特征线性回归

ex1data2.txt中的数据是二个特征,作一个最简单的多元(在此为二元)线性回归即可:$y=a_1x_1+a_2x_2+b$。

对ex1data2.txt中的数据进行线性回归,所有样本都用来训练和预测。

代码实现如下:

1 | """ |

结果如下:

由下可知函数形式以及$R^2$为0.73

1 | [ 139.21067402 -8738.01911233] |

两份数据

ex1data1.txt

1 | 6.1101,17.592 |

ex1data2.txt

1 | 2104,3,399900 |

作者:@臭咸鱼

转载请注明出处:https://www.cnblogs.com/chouxianyu/

欢迎讨论和交流!